在自动驾驶领域,技术的演进如同一场接力赛,从早期的基于规则的系统,到端到端模型,再到视觉语言模型(VLM),如今已经发展到视觉语言行动模型(VLA)阶段。每一步的跨越,都不仅仅是技术的迭代,“人工智能”实质性应用的范例。

什么是VLA?

VLA(Vision-Language-Action Model)是视觉-语言-行为大模型,它融合了视觉、语言和行动三种能力,将其统一在一个模型里,只输入到机器就可执行动作的端到端映射,从而赋予模型强大的3D空间理解、逻辑推理和行为生成能力,让自动驾驶能够感知、思考和适应环境。

VLA模型由多个关键模块组成,包括视觉编码器、语言编码器、跨模态融合模块和动作生成模块。视觉编码器负责从图像或视频中提取高层次视觉特征,语言编码器则处理自然语言输入,跨模态融合模块将视觉和语言特征进行整合,而动作生成模块则根据融合后的信息生成车辆的控制指令。

VLA的核心特性包括多模态感知与决策、全局上下文理解和系统透明性。它能够基于视觉和语言信息进行实时感知,并通过“思维链”技术构建类人逻辑,推理复杂场景下的最优驾驶决策。此外,VLA能够理解长达数十秒的全局路况信息,这对于施工工区、潮汐车道等复杂场景尤为重要。最重要的是,VLA的推理过程全程可求导,能够通过车载显示向用户解释驾驶逻辑,增强用户信任感。

VLA能干嘛?

最早的辅助驾驶采用模块化架构,由于感知、规划及执行系统相对独立,且每个步骤都要占用一定的计算时间,整体系统的响应较慢,延时较高。简单来说就是需要在既定的规则下,同时依赖高精地图,类似蚂蚁的行动和完成任务的方式。但无法完成更复杂的事情,需要不断地加限定规则。

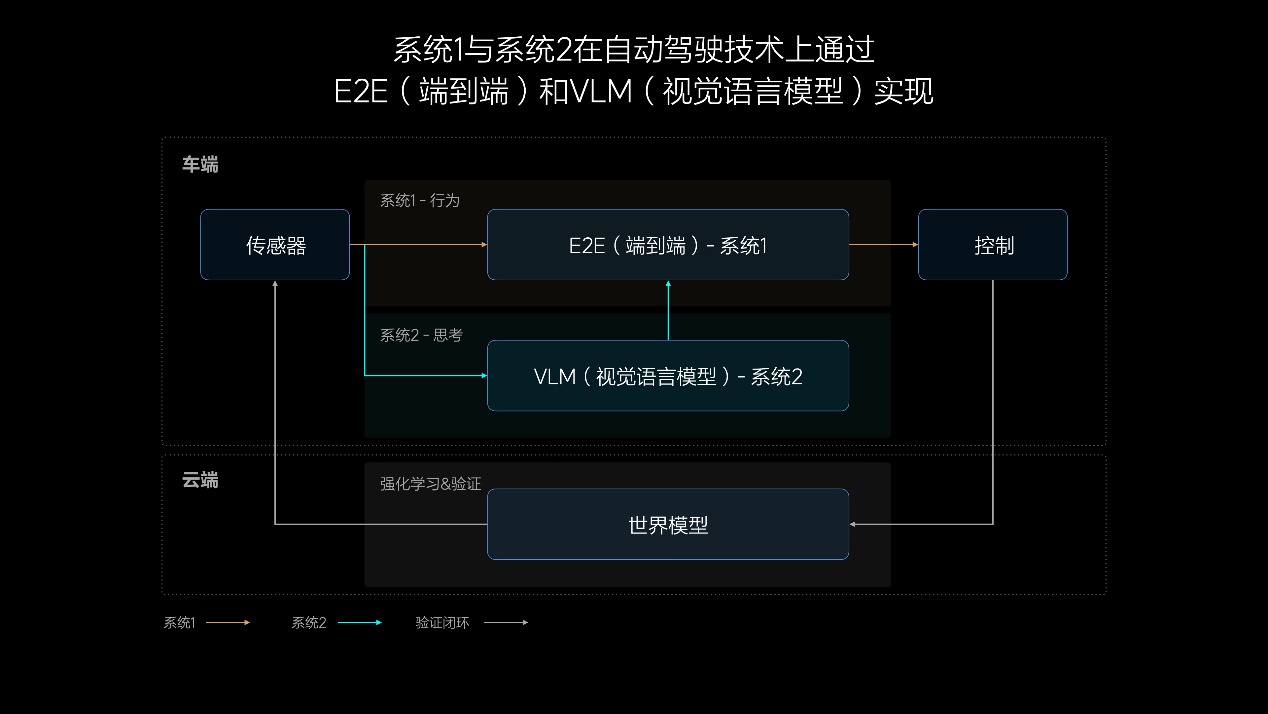

后期,端到端阶段通过大模型学习人类驾驶行为,足以应对大部分泛化场景,但很难解决从未遇到过或特别复杂的问题,此时需要配合VLM(视觉语言模型)。VLM模型对复杂交通环境具有更强的理解能力,但现有视觉语言模型在应对复杂交通环境时只能起到辅助作用。

当来到VLA阶段,利用3D视觉和2D的组合构建更真实的物理世界,此阶段系统可实现看懂导航软件的运行逻辑,而非VLM阶段仅能看到一张图。同时,VLA不仅能看到物理世界,更能理解物理世界,具有自己的语言和思维链系统,有推理能力,可以像人类一样去执行一些复杂动作,在汽车自动驾驶领域称之为VLA的司机大模型。

简单来说,VLA能够更好的处理人类驾驶行为的多模态性,可以适应更多驾驶风格。

在海量的优质数据的加持下,VLA模型在绝大多数场景下能接近人类的驾驶水平;随着偏好数据的逐步丰富,模型的表现也逐步接近专业司机的水平,安全下限也得到了巨大的提升。最后,VLA能够解决到全自动驾驶,甚至有机会超过人类开车能力的一种方式。

世界模型又是什么?

世界模型(World Model)通过构建一个虚拟的环境模型,来模拟和预测真实世界中的交通场景。

世界模型的核心是通过感知数据和语言信息,构建一个包含交通规则、道路结构和动态物体的虚拟环境。这个模型不仅能够反映当前的交通状况,还能够预测未来一段时间内的变化。

世界模型能够为VLA模型提供更丰富的上下文信息,帮助模型更好地理解复杂场景。其次,世界模型可以用于模拟训练,通过生成虚拟的交通场景,为自动驾驶模型提供更多的训练数据。此外,世界模型还可以用于安全验证,通过模拟各种极端场景,验证自动驾驶模型的安全性和可靠性。

换句话说,世界模型有点像摸底考试,通过预先对VLA一类的模型进行测试,提高模型的效率和安全性。

目前,VLA模型的训练和部署面临着巨大的计算挑战。未来,随着分布式训练技术的不断发展,如张量并行和流水线并行,VLA模型的训练效率将大幅提高。此外,通过优化模型架构和采用混合精度训练等技术,模型的部署成本也将显著降低。(朋月)